Inhaltsverzeichnis

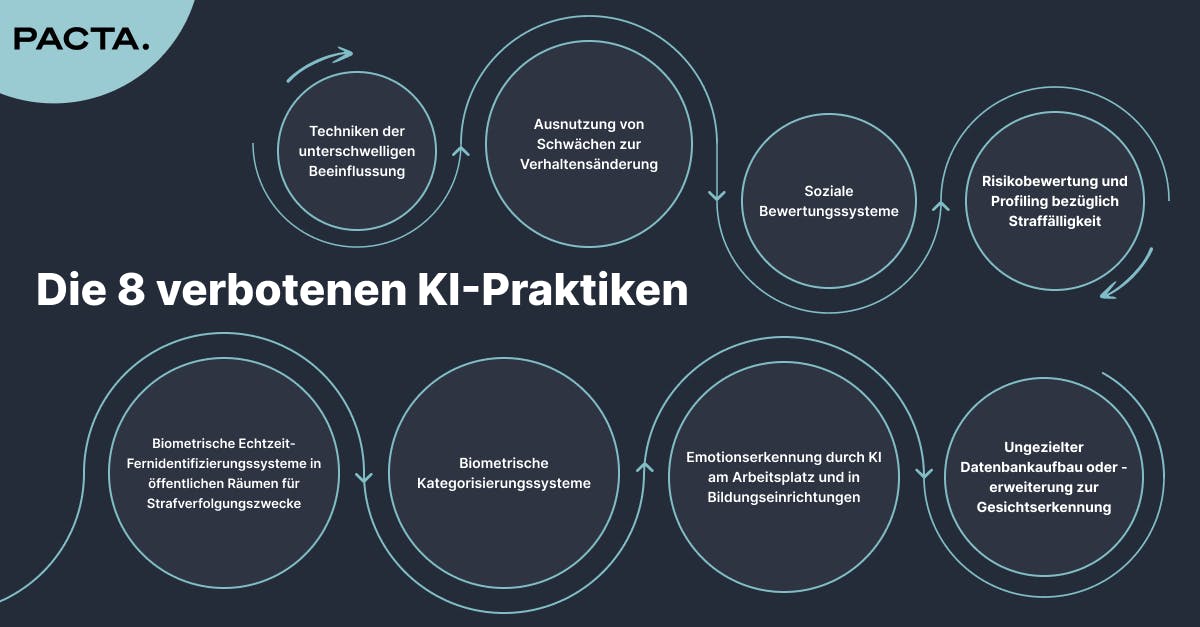

Erste verbotene KI-Praktik: Techniken der unterschwelligen Beeinflussung

Zweite verbotene KI-Praktik: Ausnutzung von Schwächen zur Verhaltensänderung

Dritte verbotene KI-Praktik: Soziale Bewertungssysteme

Vierte verbotene KI-Praktik: Risikobewertung und Profiling bezüglich Straffälligkeit

Fünfte verbotene KI-Praktik: Ungezielter Datenbankaufbau oder -erweiterung zur Gesichtserkennung

Sechste verbotene KI-Praktik: Emotionserkennung durch KI am Arbeitsplatz und in Bildungseinrichtungen

Siebte verbotene KI-Praktik: Biometrische Kategorisierungssysteme

Achte verbotene KI-Praktik: Biometrische Echtzeit-Fernidentifizierungssysteme in öffentlichen Räumen für Strafverfolgungszwecke

Wie ist im Unternehmen zu reagieren?

Fazit

Verbotene KI-Praktiken (Schwerpunkt: Artikel 5 KI-VO)

In der heutigen digitalen Welt wird Künstliche Intelligenz (KI) immer wichtiger. Doch es gibt auch viele Risiken und Herausforderungen, die mit ihrer Nutzung verbunden sind. Besonders die EU hat strenge Regeln aufgestellt, um unethische Praktiken zu verhindern. In diesem Artikel werfen wir einen Blick auf die verbotenen KI-Praktiken, wie sie in Artikel 5 der EU-KI-Verordnung festgelegt sind.

Erste verbotene KI-Praktik: Techniken der unterschwelligen Beeinflussung

Nach Artikel 5(1)(a) KI-VO ist zunächst folgende KI-Praktik verboten: “[D]as Inverkehrbringen, die Inbetriebnahme oder die Verwendung eines KI-Systems, das unterschwellige Techniken, die sich dem Bewusstsein einer Person entziehen, oder absichtlich manipulative oder täuschende Techniken einsetzt, mit dem Ziel oder der Wirkung, das Verhalten einer Person oder Personengruppe dadurch wesentlich zu beeinflussen, dass ihre Fähigkeit, eine sachkundige Entscheidung zu treffen, spürbar beeinträchtigt wird, wodurch sie veranlasst wird, eine Entscheidung zu treffen, die sie andernfalls nicht getroffen hätte, und zwar in einer Weise, die dieser Person, einer anderen Person oder einer Personengruppe einen erheblichen Schaden zufügt oder mit hinreichender Wahrscheinlichkeit zufügen wird.”

Unterschwellige Elemente wie Audio-, Bild- oder Videostimuli können sich der menschlichen Wahrnehmung entziehen und daher eine besondere Beeinträchtigung der Autonomie und freien Wahl der Nutzenden darstellen. Dem Nutzenden ist möglicherweise sogar gar nicht mehr bewusst, dass er es mit einer solch manipulativen, täuschenden Technik zu tun hat. Ein Kontrollverlust findet statt, der KI-Technik zu widerstehen ist aufgrund gegebener Situation für den Nutzenden nicht mehr möglich.

Besonders anfällig für Ausbeutung durch KI-Systeme sind weiterhin Menschen, die durch Armut, Religion oder Ethnie einer Minderheit angehören.

Zweite verbotene KI-Praktik: Ausnutzung von Schwächen zur Verhaltensänderung

Laut Artikel 5(1)(b) ist weiterhin folgende KI-Praktik verboten: “[D]as Inverkehrbringen, die Inbetriebnahme oder die Verwendung eines KI-Systems, das eine Schwachstelle einer natürlichen Person oder einer bestimmten Personengruppe aufgrund ihres Alters, einer Behinderung oder einer besonderen sozialen oder wirtschaftlichen Situation ausnutzt, mit dem Ziel oder der Wirkung, das Verhalten dieser Person oder einer Person, die dieser Gruppe angehört, in einer Weise wesentlich zu beeinflussen, die dieser Person oder einer anderen Person einen erheblichen Schaden zufügt oder mit hinreichender Wahrscheinlichkeit zufügen wird.”

Damit sind solche KI-Praktiken verboten, die die Schwäche und Schutzbedürftigkeit von Personen, unter anderem Kindern, Pflegebedürftigen und Menschen mit Handicap, ausnutzen. Ein Beispiel für eine solche KI-Praktik wären Systeme, die durch direkte neuronale Schnittstellen das Verhalten von Nutzern beeinflussen, z. B. indem sie durch Reizüberflutung oder gezielte emotionale Manipulation das Kaufverhalten oder die Loyalität zu bestimmten Marken stärken. Durch die direkte Beeinflussung des Gehirns sind die Nutzer dieser Kontrolle oft schutzlos ausgeliefert, was potenziell erheblichen finanziellen und psychischen Schaden verursachen könnte.

Dritte verbotene KI-Praktik: Soziale Bewertungssysteme

Artikel 5(1)(c) verbietet weiterhin “das Inverkehrbringen, die Inbetriebnahme oder die Verwendung von KI‑Systemen zur Bewertung oder Einstufung von natürlichen Personen oder Gruppen von Personen über einen bestimmten Zeitraum auf der Grundlage ihres sozialen Verhaltens oder bekannter, abgeleiteter oder vorhergesagter persönlicher Eigenschaften oder Persönlichkeitsmerkmale, wobei die soziale Bewertung zu einem oder beiden der folgenden Ergebnisse führt:

- Schlechterstellung oder Benachteiligung bestimmter natürlicher Personen oder Gruppen von Personen in sozialen Zusammenhängen, die in keinem Zusammenhang zu den Umständen stehen, unter denen die Daten ursprünglich erzeugt oder erhoben wurden;

- Schlechterstellung oder Benachteiligung bestimmter natürlicher Personen oder Gruppen von Personen in einer Weise, die im Hinblick auf ihr soziales Verhalten oder dessen Tragweite ungerechtfertigt oder unverhältnismäßig ist (...)”.

Die KI-Verordnung möchte hiermit Diskriminierung und Stigmatisierung aufgrund von Ethnie, Geschlecht, Glauben und politischer Meinung unterbinden. Social Scoring, also die algorithmische Bewertung von Personen, kann weitreichende Auswirkungen für die Gesellschaft haben. Beispiele wie das chinesische “Social Credit System” verdeutlichen die Risiken solcher Bewertungssysteme: Diese können in sozialen Kontexten das Verhalten von Individuen beeinflussen und gesellschaftliche Hierarchien schaffen, basierend auf der maschinellen Auswertung sozialer oder persönlicher Eigenschaften. Der Algorithmus aufgrund seiner oft undurchsichtigen Entscheidungsfindung und der potenziellen Datenverzerrung kann Ungerechtigkeit schaffen. Historische Vorurteile werden reproduziert und erfahren durch die algorithmische Verarbeitung Verstärkung, was zu einer Dynamik namens “Automated Bias Loop” führt, wobei Vorurteile und Diskriminierungen durch wiederholte algorithmische Entscheidungen stabilisiert werden.

Vierte verbotene KI-Praktik: Risikobewertung und Profiling bezüglich Straffälligkeit

Ein weiterer zentraler Bestandteil des Artikel 5 ist das Verbot, KI-Systeme ausschließlich zur Vorhersage krimineller Handlungen auf Basis von Profiling oder der Analyse persönlicher Merkmale und Eigenschaften einzusetzen: Verboten ist nach Art. 5(1)(d) “das Inverkehrbringen, die Inbetriebnahme für diesen spezifischen Zweck oder die Verwendung eines KI‑Systems zur Durchführung von Risikobewertungen in Bezug auf natürliche Personen, um das Risiko, dass eine natürliche Person eine Straftat begeht, ausschließlich auf der Grundlage des Profiling einer natürlichen Person oder der Bewertung ihrer persönlichen Merkmale und Eigenschaften zu bewerten oder vorherzusagen; dieses Verbot gilt nicht für KI‑Systeme, die dazu verwendet werden, die durch Menschen durchgeführte Bewertung der Beteiligung einer Person an einer kriminellen Aktivität, die sich bereits auf objektive und überprüfbare Tatsachen stützt, die in unmittelbarem Zusammenhang mit einer kriminellen Aktivität stehen, zu unterstützen”.

Die zunehmende Nutzung von KI zur Kriminalitätsvorhersage und -verhütung hat in den letzten Jahren Besorgnis über die ethischen und sozialen Auswirkungen dieser Technologien ausgelöst. Beispiele wäre KI-Systeme, die eine Person allein anhand ihres Profils (z. B. Staatsangehörigkeit, Wohnort oder Verschuldungsgrad) als potenziell kriminell einstufen, ohne dass konkrete und objektive Verdachtsmomente vorliegen; Systeme, die allein aufgrund von Persönlichkeitsmerkmalen oder Eigenschaften wie dem Geburtsort oder Fahrzeugtyp einer Person deren Neigung zu Straftaten einschätzen; und solche, die bestimmte soziale Merkmale wie Anzahl der Kinder oder den Wohnort einer Person nutzen, um Rückschlüsse auf die Wahrscheinlichkeit krimineller Aktivitäten zu ziehen, Profiling-Algorithmen, die rein auf statistischen Analysen persönlicher Merkmale basieren, können das Risiko für Verzerrungen und Diskriminierung erhöhen und zur Stigmatisierung ganzer Bevölkerungsgruppen führen. Artikel 5 der KI-VO bezieht klar Stellung gegen solche Systeme, indem er das Inverkehrbringen und die Anwendung von KI zur reinen Risikobewertung ohne objektive Grundlage verbietet. Der Einsatz von KI zur Unterstützung von Risikobewertungen ist laut der Verordnung nur dann zulässig, wenn menschliche Bewertungen vorliegen, die auf überprüfbaren Fakten und einem konkreten Bezug zur kriminellen Aktivität basieren.

Fünfte verbotene KI-Praktik: Ungezielter Datenbankaufbau oder -erweiterung zur Gesichtserkennung

In Art. 5(1)(e) KI-VO legt die EU klare Grenzen für den Aufbau und die Erweiterung von Gesichtserkennungsdatenbanken durch KI-Systeme fest. Insbesondere verbietet sie das ungezielte Auslesen von Gesichtsbildern aus dem Internet oder von Überwachungsaufnahmen zur Schaffung oder Erweiterung solcher Datenbanken: Verboten ist “das Inverkehrbringen, die Inbetriebnahme für diesen spezifischen Zweck oder die Verwendung von KI‑Systemen, die Datenbanken zur Gesichtserkennung durch das ungezielte Auslesen von Gesichtsbildern aus dem Internet oder von Überwachungsaufnahmen erstellen oder erweitern”.

Die Erhebung und Verwendung biometrischer Daten, insbesondere Gesichtsdaten, stellt einen erheblichen Eingriff in die Privatsphäre der betroffenen Personen dar. Biometrische Merkmale sind besonders schützenswert, da sie einzigartig und unveränderlich sind. Im Gegensatz zu herkömmlichen personenbezogenen Daten wie Telefonnummern oder Adressen können biometrische Daten nicht einfach geändert oder gelöscht werden, wenn ihre Sicherheit gefährdet ist. Einmal erfasste biometrische Daten könnten für lebenslange Überwachungszwecke missbraucht werden. Artikel 5 der KI-VO zielt darauf ab, eine unkontrollierte und unbefugte Überwachung der Öffentlichkeit zu verhindern, die zu einem Verlust der persönlichen Autonomie und einer allgemeinen Stigmatisierung führen könnte. Das ungezielte Sammeln von Gesichtsbildern aus öffentlichen oder digitalen Räumen steht im Konflikt mit dem Recht auf Privatsphäre und informationelle Selbstbestimmung.

Sechste verbotene KI-Praktik: Emotionserkennung durch KI am Arbeitsplatz und in Bildungseinrichtungen

In Art. 5(1)(f) KI-VO wird die Nutzung von KI-Systemen zur Emotionserkennung im beruflichen und schulischen Umfeld erheblich eingeschränkt. Der Artikel verbietet „das Inverkehrbringen, die Inbetriebnahme für diesen spezifischen Zweck oder die Verwendung von KI‑Systemen zur Ableitung von Emotionen einer natürlichen Person am Arbeitsplatz und in Bildungseinrichtungen, es sei denn, die Verwendung des KI‑Systems soll aus medizinischen Gründen oder Sicherheitsgründen eingeführt oder auf den Markt gebracht werden.“

Die Emotionserkennung durch KI umfasst die Analyse von Gesichtsausdrücken, Stimmton, Körperhaltung und anderen biometrischen Indikatoren, um den emotionalen Zustand einer Person abzuleiten. Am Arbeitsplatz und in Bildungseinrichtungen werden solche Systeme zunehmend in Pilotprojekten getestet, etwa um das Engagement von Mitarbeitern zu messen oder die Aufmerksamkeit und das Befinden von Schülern zu überwachen. Die potenzielle Verbreitung dieser Systeme wirft jedoch erhebliche ethische und datenschutzrechtliche Fragen auf. Durch die Vorgaben in Artikel 5 der KI-VO wird die unregulierte Nutzung dieser Technologie unterbunden, um die Privatsphäre und das Recht auf informationelle Selbstbestimmung zu schützen. Emotionserkennende KI-Systeme weisen darüber hinaus oft Verzerrungen auf, insbesondere wenn sie auf Trainingsdaten basieren, die nur bestimmte demografische oder kulturelle Gruppen abbilden. Dies kann dazu führen, dass emotionale Reaktionen bestimmter Personengruppen nicht genau oder falsch interpretiert werden. Diese Fehleranfälligkeit kann insbesondere im beruflichen und schulischen Umfeld schwerwiegende Folgen haben, wenn emotionale Zustände unzutreffend bewertet werden und möglicherweise berufliche Chancen oder Bildungsentscheidungen beeinflussen.

Siebte verbotene KI-Praktik: Biometrische Kategorisierungssysteme

Art. 5(1)(g) KI-VO verbietet ausdrücklich den Einsatz von KI-Systemen zur biometrischen Kategorisierung, die auf Basis biometrischer Daten sensible Merkmale wie Rasse, politische Ansichten, religiöse Überzeugungen, sexuelle Orientierung oder Gewerkschaftszugehörigkeit ableiten: Verboten ist somit “das Inverkehrbringen, die Inbetriebnahme für diesen spezifischen Zweck oder die Verwendung von Systemen zur biometrischen Kategorisierung, mit denen natürliche Personen individuell auf der Grundlage ihrer biometrischen Daten kategorisiert werden, um ihre Rasse, ihre politischen Einstellungen, ihre Gewerkschaftszugehörigkeit, ihre religiösen oder weltanschaulichen Überzeugungen, ihr Sexualleben oder ihre sexuelle Ausrichtung zu erschließen oder abzuleiten; dieses Verbot gilt nicht für die Kennzeichnung oder Filterung rechtmäßig erworbener biometrischer Datensätze, wie z. B. Bilder auf der Grundlage biometrischer Daten oder die Kategorisierung biometrischer Daten im Bereich der Strafverfolgung”.

Dieses Verbot zielt darauf ab, die Gefahr von Diskriminierung und Eingriffen in die Privatsphäre zu minimieren, die mit der Erhebung und Verarbeitung solcher sensibler Daten einhergeht. Ein Hauptgrund für diese Einschränkung liegt in der starken Schutzbedürftigkeit biometrischer Daten, die unter die besonders sensiblen personenbezogenen Daten fallen und daher hohen datenschutzrechtlichen Anforderungen unterliegen. Laut Artikel 9 der Datenschutz-Grundverordnung (DSGVO) bedürfen biometrische Daten, wenn sie zur Identifizierung verwendet werden, einer speziellen Schutzmaßnahme. Die KI-VO betrachtet darüber hinaus die biometrische Kategorisierung als besonders risikobehaftet, da Algorithmen leicht zu diskriminierenden Ergebnissen führen können, besonders wenn sie fehlerhafte Annahmen über sensible persönliche Merkmale treffen.

Das Verbot enthält eine Ausnahme für die Filterung und Kategorisierung biometrischer Daten, die bereits legal erhoben wurden, sofern diese Prozesse für spezifische Zwecke im Bereich der Strafverfolgung eingesetzt werden. Hiermit soll die öffentliche Sicherheit gewahrt werden, ohne jedoch die individuellen Rechte in anderen Kontexten zu gefährden. Im Bereich der Strafverfolgung ist die Kategorisierung erlaubt, jedoch nur unter streng geregelten Rahmenbedingungen und transparenter Berichterstattung, um Missbrauch zu verhindern.

Achte verbotene KI-Praktik: Biometrische Echtzeit-Fernidentifizierungssysteme in öffentlichen Räumen für Strafverfolgungszwecke

Art. 5(1)(h) KI-VO sieht ein generelles Verbot für die Nutzung biometrischer Echtzeit-Fernidentifizierungssysteme in öffentlich zugänglichen Räumen für Strafverfolgungszwecke vor: Verboten ist “die Verwendung biometrischer Echtzeit-Fernidentifizierungssysteme in öffentlich zugänglichen Räumen zu Strafverfolgungszwecken, außer wenn und insoweit dies im Hinblick auf eines der folgenden Ziele unbedingt erforderlich ist:

- gezielte Suche nach bestimmten Opfern von Entführung, Menschenhandel oder sexueller Ausbeutung sowie die Suche nach vermissten Personen;

- Abwenden einer konkreten, erheblichen und unmittelbaren Gefahr für das Leben oder die körperliche Unversehrtheit natürlicher Personen oder einer tatsächlichen und bestehenden oder tatsächlichen und vorhersehbaren Gefahr eines Terroranschlags;

- Aufspüren oder Identifizieren einer Person, die der Begehung einer Straftat verdächtigt wird, zum Zwecke der Durchführung von strafrechtlichen Ermittlungen oder von Strafverfahren oder der Vollstreckung einer Strafe für die in Anhang II aufgeführten Straftaten, die in dem betreffenden Mitgliedstaat nach dessen Recht mit einer Freiheitsstrafe oder einer freiheitsentziehenden Maßregel der Sicherung im Höchstmaß von mindestens vier Jahren bedroht ist.”

Diese Systeme, die oft Gesichtserkennungstechnologien verwenden, stellen ein erhebliches Risiko für die Privatsphäre und Grundrechte dar, weshalb ihre Nutzung auf obige Ausnahmefälle beschränkt ist, bei denen sie als unverzichtbar gelten.

Wie ist im Unternehmen zu reagieren?

- Das Nutzen von verbotenen KI-Praktiken unterlassen.

- Einen KI-Verantwortlichen im Unternehmen benennen, welcher im Unternehmen bestehende KI-Systeme bezüglich ihres Risikos analysiert und gegebenenfalls aus der Unternehmenspraxis streicht. Dabei muss insbesondere auf solche Praktiken geachtet werden, die möglicherweise auf verbotene Techniken hindeuten oder sich zukünftig zu solchen entwickeln könnten.

- Das Aufstellen eines Code of AI-Ethics, mit dem das Unternehmen ethische Regeln für die Nutzung von KI festlegt. Die Umsetzung dieses Kodexes wird dabei vom unternehmenseigenen KI-Verantwortlichen überwacht.

Fazit

Deutlich werden hier die zunehmende Bedeutung strikter Vorschriften zur KI-Regulierung in der EU und die Risiken manipulativer, diskriminierender und unethischer KI-Praktiken, die nach Artikel 5 KI-VO verboten sind. Diese Vorschrift zielt darauf ab, den Schutz der Autonomie, Privatsphäre und sozialen Integrität von Menschen sicherzustellen und verhindert, dass KI-Technologien zur Erzeugung oder Verstärkung von Vorurteilen und sozialen Ungleichheiten missbraucht werden. Konkret werden Techniken der unterschwelligen Beeinflussung, die Ausnutzung von Schwächen, soziale Bewertungssysteme sowie KI-gestützte Profiling-Methoden zur Vorhersage kriminellen Verhaltens, ungezielter Aufbau von Gesichtserkennungsdatenbanken, Emotionserkennung, biometrische Kategorisierungen und Echtzeit-Fernidentifizierungssysteme in öffentlichen Räumen als verbotene Praktiken identifiziert.

Unternehmen sind gefordert, die Nutzung solcher Technologien konsequent zu vermeiden und ethische Leitlinien im Umgang mit KI zu etablieren. Ein Unternehmensansatz könnte die Benennung eines KI-Verantwortlichen und die Einführung eines „Code of AI-Ethics“ umfassen, der den ethischen Einsatz von KI festlegt und die Einhaltung der regulatorischen Anforderungen sicherstellt. Damit wird ein Rahmen geschaffen, in dem KI-Systeme verantwortungsvoll eingesetzt werden können, ohne die Rechte und Freiheiten der Menschen zu gefährden.