AI Act – Die Maßstäbe der EU-KI-Verordnung

Die EU-KI-Verordnung ist ein neuer Rechtsrahmen, der die Entwicklung und Nutzung von Künstlicher Intelligenz (KI) in der Europäischen Union regeln soll. Diese Verordnung (“KI-VO”) zielt darauf ab, die Sicherheit, Transparenz und Verantwortung im Umgang mit KI-Systemen zu gewährleisten und damit auch das Vertrauen der Öffentlichkeit in diese Technologien zu stärken, um langfristig Innovationen zu fördern. Dieser Artikel thematisiert die grundsätzlichen Maßstäbe der KI-VO, namentlich die Unterscheidung zwischen KI-Systemen und –Modellen sowie die Risikobewertung eines KI-Systems, und markiert zudem den Start unserer Blog-Serie zur KI-Regulierung der EU.

Unterscheidung zwischen KI-Systemen und KI-Modellen

Zunächst unterscheidet die KI-VO grundlegend zwischen KI-Systemen und KI-Modellen.

(Einfache) KI-Systeme

Ein KI-System ist definiert als „ein maschinengestütztes System, das so konzipiert ist, dass es mit unterschiedlichem Grad an Autonomie betrieben werden kann, das nach der Einführung Anpassungsfähigkeit zeigen kann und das für explizite oder implizite Ziele aus den Eingaben, die es erhält, ableitet, wie es Ergebnisse wie Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen erzeugen kann, die physische oder virtuelle Umgebungen beeinflussen können“, Art. 3 I KI-VO. Hervorzuheben sind hier zwei bestimmte Eigenschaften: die Autonomie und eine gewisse Lernkapazität. Das bedeutet, dass ein KI-System unabhängig von menschlicher Unterstützung funktioniert, Datensätze verarbeitet, neue Sachverhalte analysiert und sich an diese anpassen kann. Weitere Informationen zu den riskanten KI-Systemen finden Sie im Abschnitt “KI-Systeme und ihre Risikostufen” weiter unten im Text.

Wichtig ist auch, dass nicht alle KI-Systeme in den Anwendungsbereich der KI-VO fallen. Ausgenommen von der Verordnung sind:

- KI-Systeme, die für nationale Sicherheitszwecke eingesetzt werden (Art. 2(3) KI-VO),

- Systeme, die ausschließlich für militärische Zwecke entwickelt wurden (Art. 2(3) KI-VO),

- KI-Systeme, die nur für wissenschaftliche Forschung genutzt werden (Art. Art.2(6) KI-VO)

- und auch die Nutzung von KI-Systemen im privaten Bereich (z.B. persönliche Anwendungen wie Sprachassistenten) ist nicht betroffen (Art. 2(10) KI-VO).

Diese Ausnahmen sind entscheidend, um die Balance zwischen Sicherheit und Innovation zu wahren.

KI-(Basis)Modelle

Abzugrenzen von einem KI-System sind in der KI-VO die KI-Modelle, wobei der Fokus der Verordnung speziell auf Basismodellen liegt. Ein solches KI-Modell mit allgemeinem Verwendungszweck ist nach Art. 3 Abs. 63 KI-VO „ein KI-Modell, auch wenn es mit einer großen Datenmenge unter Verwendung von Selbstüberwachung in großem Maßstab trainiert wurde, das eine erhebliche Allgemeinheit aufweist und in der Lage ist, ein breites Spektrum unterschiedlicher Aufgaben kompetent auszuführen, unabhängig davon, wie das Modell auf den Markt gebracht wird, und das in eine Vielzahl nachgelagerter Systeme oder Anwendungen integriert werden kann (...)“.

Die Popularität sogenannter „General Purpose AI“ wie ChatGPT oder DALL-E steigt stetig an und ist damit auch bei der europäischen KI-Regulierung nicht mehr wegzudenken. Die EU wagt somit den Schritt, nicht nur die KI-Anwendung, ergo das fertige „Produkt“, sondern auch die darunterliegende Technologie „unabhängig von ihrer letzten Anwendung“ zu regulieren.

Die Anbieter von KI-Modellen mit allgemeinem Verwendungszweck sind nach der KI-Verordnung zur Offenlegung grundsätzlicher Informationen verpflichtet: Sie müssen technische Unterlagen aktualisieren und bereitstellen (Art. 53(1)a),b) KI-VO), eine Strategie zur Einhaltung der Urheberrechtslinien entwickeln (Art. 53(1)c) KI-VO) und ihre Trainingsinhalte publizieren (Art. 53(1)d) KI-VO).

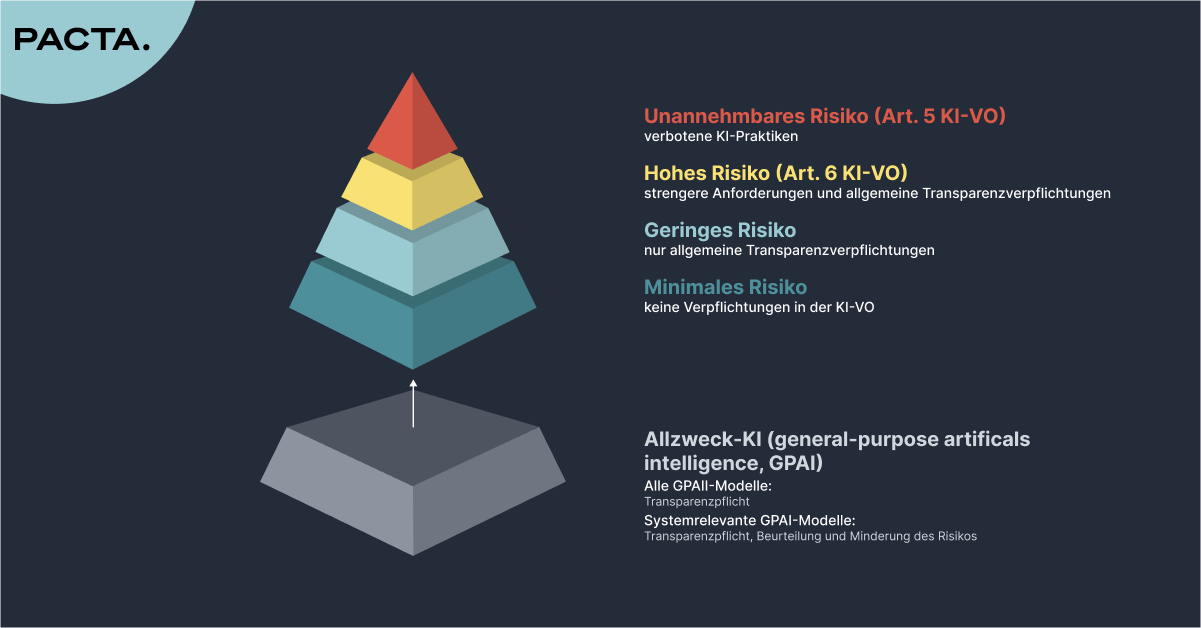

Auch eine GPAI kann als „riskant“ eingestuft werden – in dem Fall kommen zusätzlich zu den eben genannten Anforderungen noch strengere Pflichten auf Anbieter zu: Sie müssen Modellbewertungen und Angriffstests beim Modell durchführen und dokumentieren (Art. 55(1)a),b) KI-VO), schwerwiegende Vorfälle verfolgen und melden (Art. 55(1)c) KI-VO) sowie Cybersicherheit gewährleisten (Art. 55(1)d) KI-VO). Weiterhin müssen alle relevanten Unterlagen bereitgestellt werden, um Anbieter von KI-Anwendungen – also jene, die die GPAI in ihr KI-System integrieren wollen – über die Eigenschaften des KI-Modells mit allgemeinem Verwendungszweck zu informieren (Art. 55(1)b) KI-VO). Ab wann ein GPAI mit systemischem Risiko vorliegt, erfahren Sie in unserem nächsten Blogartikel.

KI-Systeme und ihre Risikostufen

Die EU-KI-Verordnung klassifiziert KI-Systeme in vier Risikokategorien (nicht hinnehmbar, hoch, gering, minimal), um den unterschiedlichen Gefahren, die von ihnen ausgehen, gerecht zu werden.Diese Kategorien helfen, die Sicherheit und die Rechte der Menschen zu schützen. Je höher das Risiko des KI-Systems, desto strenger sind die einzuhaltenden Pflichten.

Nicht hinnehmbares Risiko (verboten)

Diese KI-Systeme sind aufgrund ihres hohen Risikos für die Gesellschaft und den Einzelnen gemäß Art. 5 KI-VO verboten. Hierunter fallen unter anderem KI-Systeme, die zur Echtzeit-Fernidentifizierung natürlicher Personen biometrische Daten erfassen, und KI-Praktiken wie kognitive Verhaltensmanipulation und Social Scoring, ergo Systeme, die das Verhalten von Personen bewerten und darauf basierend Vorteile oder Nachteile gewähren.

Hohes Risiko (strengere Anforderungen neben den allgemeinen Transparenzverpflichtungen gem. Art. 50 KI-VO)

Hochrisiko-KI-Systeme sind solche, die erhebliche Auswirkungen auf die Gesundheit und Sicherheit der Menschen haben können. Beispiele sind KI in kritischen Infrastrukturen, in der Bildung (insbesondere wenn sie den Zugang zu Bildung beeinflusst) und in der Strafverfolgung, die die Grundrechte der Menschen, wie die Menschenwürde, die Versammlungs- und Vereinigungsfreiheit und die Freiheit der Meinungsäußerung, berührt. Hochrisiko-KI-Systeme müssen bestimmte, strengere Anforderungen, die in der EU-KI-Verordnung festgelegt sind, erfüllen, um sicher und effektiv zu sein. So müssen Anbieter unter anderem ein Qualitätsmanagementsystem einrichten (Art. 17 KI-VO), das die Einhaltung der Vorschriften sicherstellt, und ein Risikomanagementsystem implementieren (Art. 9 KI-VO), das den gesamten Lebenszyklus des KI-Systems abdeckt.

Eine weitere zentrale Anforderung der Verordnung betrifft die Datenqualität und -verarbeitung. Laut Art. 10 KI-VO müssen alle Anbieter von Hochrisiko-KI-Systemen sicherstellen, dass die verwendeten Datensätze vollständig, repräsentativ und frei von Verzerrungen sind. Diese Datenanforderungen sind essentiell, um sicherzustellen, dass die KI-Systeme nicht zu diskriminierenden oder ungenauen Ergebnissen führen. Anbieter sind verpflichtet, umfangreiche Tests durchzuführen, um potenzielle Verzerrungen in den Trainingsdaten zu identifizieren und zu beheben.

Geringes Risiko (allgemeine Transparenzverpflichtungen gem. Art. 50 KI-VO)

Geringe Risiken sind mit KI-Systemen verbunden, die keine signifikanten Bedrohungen darstellen. Hierunter fallen Emotionserkennungssysteme, Systeme zur biometrischen Kategorisierung und jene, die KI-generierte oder veränderte Audio-, Bild-, Video- und Textinhalte erstellen. Diese Systeme unterliegen einzig den in Art. 50 KI-VO aufgezählten einfachen Transparenzverpflichtungen. Obwohl sie nur ein geringes Risiko für die Sicherheit und Grundrechte darstellen, muss der Nutzende informiert werden, wenn er mit einem solchen System interagiert, um Missverständnisse oder mögliche negative Auswirkungen zu minimieren.

Minimales Risiko

Minimale Risiken beziehen sich auf KI-Systeme, die als sicher gelten und keine negativen Auswirkungen auf die Gesellschaft haben. Dazu gehören einfache Anwendungen wie Spamfilter, KI-gestützte Textvervollständigung oder einfache Chatbots. Die klare Abgrenzung zwischen geringem und minimalem Risiko ist ein Schlüsselelement der EU-KI-Verordnung. Während geringes Risiko bedeutet, dass gewisse Transparenzpflichten erfüllt werden müssen, da ein potenzieller Einfluss auf Nutzende besteht, stellt minimales Risiko eine Kategorie dar, in der eine solche Interaktion keine ernsthaften Auswirkungen für den Nutzenden hat und daher keine weiteren Maßnahmen erforderlich sind.

Der Verbot inakzeptabler KI-Praktiken und die strengen Anforderungen an Hochrisiko-KI-Systeme könnten Europa zu einem Vorreiter im Bereich der ethischen KI-Nutzung machen. Gleichzeitig besteht die Herausforderung darin, sicherzustellen, dass die Einhaltung der Vorschriften Innovationen nicht hemmt, sondern fördert.

Fazit

Die EU-KI-Verordnung stellt einen bedeutenden Schritt zur Regulierung der Entwicklung und Nutzung von KI-Systemen dar. Durch die Unterscheidung von KI-Systemen und KI-Modellen (mit allgemeinem Verwendungszweck) sowie die Einführung von Risikokategorien bietet die Verordnung klare Vorgaben für die Transparenz, Sicherheit und Verantwortung beim Einsatz von KI-Technologien, insbesondere den Hochrisiko-Systemen.